FLOPs 的计算

模型训练过程中大多数浮点运算都是矩阵乘法,对于一个 的矩阵 和一个 的矩阵 , 需要 次乘法和 次加法,即需要 FLOPs。

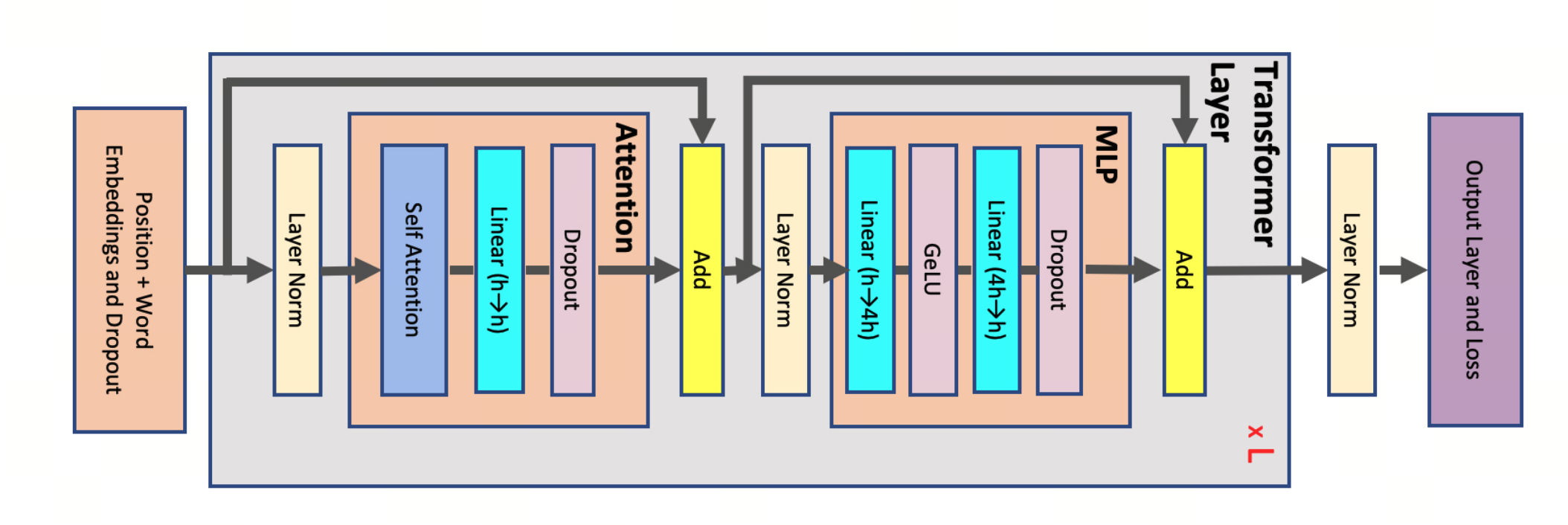

Transformer Architecture 的 FLOPs 计算

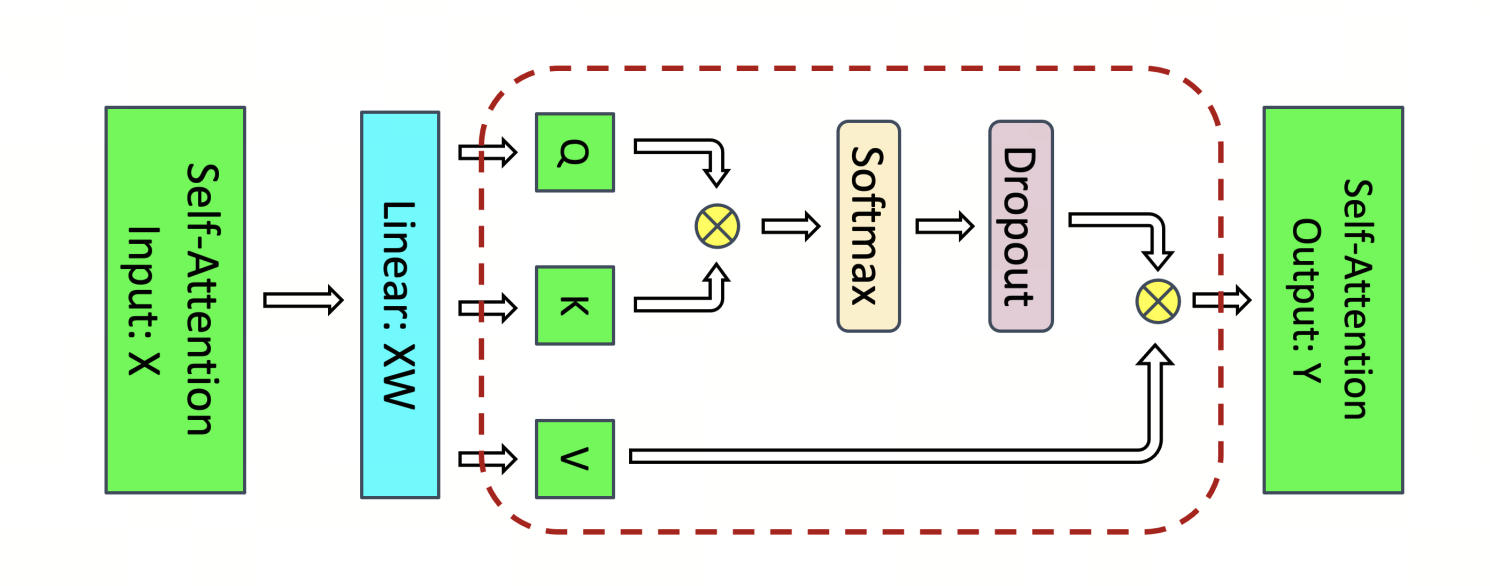

Attention

Q,K,V transformation:

:

attention over values:

post-attention linear projection:

Feed Forward Network

linear h->4h:

linear 4h->h:

Total

forward:

backward 的 FLOPs 大致是 forward 的 2 倍,所以 forward + backward 的 FLOPs 大致是

参考 Megatron-LM 2 APPENDIX